Die Implementierung autonomer KI-Agenten markiert den signifikantesten Paradigmenwechsel in der Softwarearchitektur seit der Einführung von Microservices. Während klassische Large Language Models (LLMs) als stochastische Inferenzmaschinen auf einer rein textbasierten Eingabe-Ausgabe-Ebene operieren, fungieren Agenten als dynamische Akteure. Sie sind in der Lage, komplexe Zielvorgaben in deterministische Handlungsstränge zu übersetzen und aktiv mit externen Systemen zu interagieren. Dieser Artikel analysiert die technische Anatomie dieser Systeme, vom Reasoning-Loop bis zur Tool-Orchestrierung.

Definition & Systemarchitektur Vom probabilistischen Modell zum Agenten

Technisch definiert ist ein KI-Agent eine Laufzeitumgebung, die ein LLM als zentrale kognitive Einheit (Reasoning Engine) nutzt, dieses jedoch um wesentliche Module erweitert: Wahrnehmung (Perception), Gedächtnis (Memory) und Aktorik (Tools). Im Gegensatz zu einer statischen Zero-Shot-Interaktion, bei der ein Prompt zu einer direkten Antwort führt, operiert ein Agent in einer iterativen Schleife.

Kernunterschied: Ein LLM generiert Text basierend auf Wahrscheinlichkeiten. Ein Agent generiert Verhalten basierend auf Zielen.

Der Agenten-Loop überwacht den Prozess der Problemlösung kontinuierlich. Er folgt meist dem Schema: Observation (Eingabe analysieren) → Thought (Handlung planen) → Action (Tool ausführen) → Observation (Ergebnis bewerten). Dieser Zyklus wird so lange wiederholt, bis das Abbruchkriterium (Zielerreichung oder Fehler) erfüllt ist.

Core Components Der technische Stack

Um ein robustes Agentensystem zu entwickeln, setzen Ingenieure auf Frameworks wie LangChain, AutoGen oder LlamaIndex. Diese abstrahieren die Komplexität der Prompt-Chains und API-Integrationen. Eine vollständige Agenten-Architektur besteht aus vier unverzichtbaren Säulen, die nahtlos ineinandergreifen müssen:

1. Planning (Planungsalgorithmen): Zerlegung komplexer Aufgaben in sequentielle Teilschritte (Chain of Thought, Tree of Thoughts) sowie Mechanismen zur Selbstreflexion und Fehlerkorrektur.

2. Memory (Zustandsspeicher): Verwaltung des Kontextfensters (Short-term) und Anbindung an Vektordatenbanken (Long-term) für semantischen Zugriff auf historisches Wissen.

3. Tools (Schnittstellen): Ausführbare Funktionen (API-Calls, SQL-Queries, Python-Interpreter), die dem Agenten die Manipulation der Außenwelt ermöglichen.

4. Action (Exekutive): Die konkrete Ausführung der vom Modell generierten Funktionsaufrufe durch die Laufzeitumgebung.

Reasoning & Function Calling Das Gehirn der Operation

Das Herzstück moderner Agenten ist das Function Calling (oder Tool Use). Hierbei wird das LLM nicht nur auf Textgenerierung trainiert, sondern darauf, strukturierte Daten (meist JSON) auszugeben, die einer vordefinierten Funktionssignatur entsprechen. Das Modell „erkennt“ im Kontext, dass es eine Frage nicht mit internem Wissen beantworten kann, und generiert stattdessen einen API-Aufruf.

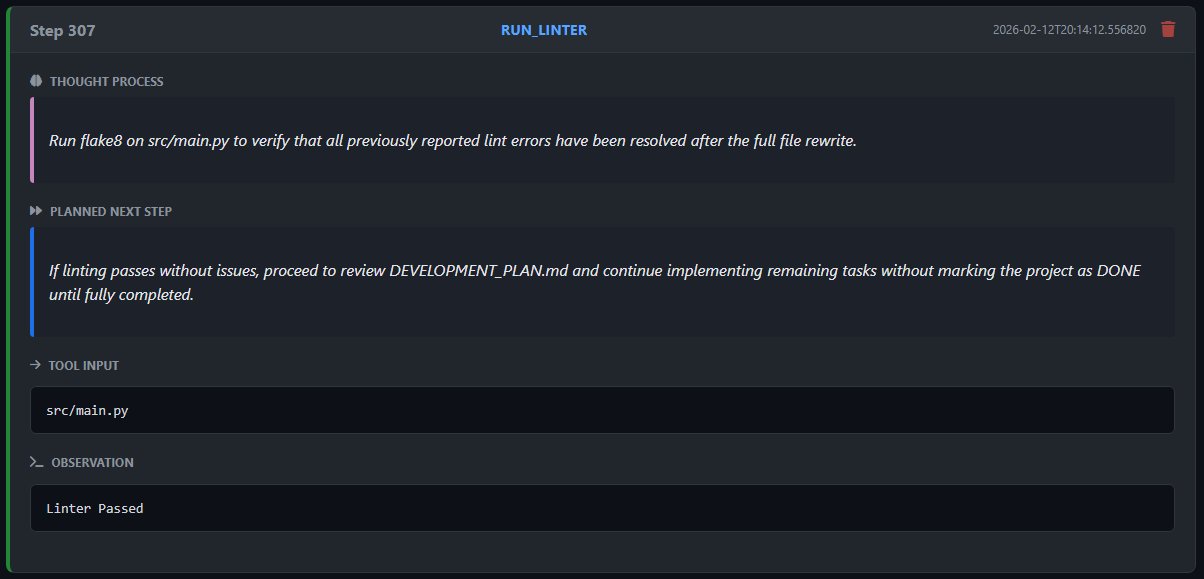

Ein weit verbreitetes Design-Pattern ist ReAct (Reasoning + Acting). Der Agent formuliert zunächst einen internen Gedanken über das Vorgehen, bevor er die Aktion spezifiziert. Dies erhöht die Transparenz und Debugging-Fähigkeit des Systems massiv.

Beispiel: ReAct-Pattern im Log

User Request: „Prüfe den Status von Server A.“

1. Thought: „Ich benötige aktuelle Telemetriedaten. Ich werde das Monitoring-Tool abfragen.“

2. Action: {"function": "get_status", "params": {"target": "server_a"}}

3. Observation: (System führt Code aus) Rückgabe: {"cpu": "99%", "status": "critical"}

4. Final Response: „Server A ist im kritischen Zustand mit 99% CPU-Last.“

Screenshot einer ReAct-Schleife eines Coding-Agenten

Persistenz & Vektordatenbanken Langzeitgedächtnis (RAG)

Da LLMs zustandslos (stateless) sind und ein begrenztes Kontextfenster besitzen, benötigen Agenten eine externe Speicherlösung für komplexe Aufgaben. Hier kommen Vektordatenbanken (z.B. Pinecone, Weaviate, Milvus) ins Spiel. Informationen werden mittels Embedding-Modellen in hochdimensionale Vektoren transformiert und indexiert.

Dies ermöglicht dem Agenten das Retrieval Augmented Generation (RAG): Anstatt alle Informationen im Prompt zu halten, sucht der Agent semantisch nach relevanten Kontextinformationen in der Datenbank, lädt diese dynamisch in seinen Arbeitsspeicher und generiert darauf basierend die Antwort. Dies reduziert Halluzinationen und ermöglicht den Zugriff auf proprietäre Unternehmensdaten.

Risikomanagement & Limits Herausforderungen im Betrieb

Der produktive Einsatz autonomer Agenten erfordert strenge Sicherheitsvorkehrungen. Ein häufiges technisches Problem sind Infinite Loops, bei denen der Agent denselben fehlerhaften Schritt endlos wiederholt, ohne seine Strategie anzupassen. Zudem besteht die Gefahr von Prompt Injections, bei denen externe Datenquellen das Verhalten des Agenten manipulieren.

Robuste Architekturen implementieren daher Guardrails: Validierungsschichten, die sowohl den Input als auch den Output des Modells gegen definierte Regelwerke prüfen (z.B. PII-Filter, Syntax-Checks), bevor eine Aktion tatsächlich ausgeführt wird.

Human-in-the-Loop: Für kritische Aktionen (z.B. Schreibzugriffe auf Datenbanken oder Finanztransaktionen) ist ein hybrider Ansatz obligatorisch. Der Agent bereitet die Aktion vor, die Exekution erfordert jedoch eine explizite Bestätigung durch einen menschlichen Operator.

Deep Dive Technische FAQs

Bei komplexen Problemen stoßen Single-Agent-Systeme an Grenzen. Multi-Agent-Frameworks orchestrieren mehrere spezialisierte Agenten (z.B. „Coder“, „Reviewer“, „Planner“). Diese Agenten kommunizieren miteinander, kritisieren gegenseitig ihre Ergebnisse und verbessern so iterativ die Lösungsqualität, ähnlich wie in einem menschlichen Entwicklungsteam.

Zusammenfassend lässt sich sagen, dass KI-Agenten die Brücke schlagen zwischen der unscharfen Welt der natürlichen Sprache und der präzisen Welt der ausführbaren Software. Die Beherrschung dieser Architektur ist der Schlüssel zur nächsten Generation der Prozessautomatisierung.

Fazit Strategischer Ausblick

Die Transformation hin zu Agentic Workflows erfordert ein Umdenken im Software-Engineering. Wir bewegen uns weg von rein deterministischer Programmierung hin zur Orchestrierung probabilistischer Modelle. Der Erfolg eines Systems hängt künftig weniger vom Code selbst ab, als vielmehr von der Qualität der Tools, dem Design der Reasoning-Loops und der Robustheit der Guardrails.

Wir stehen am Beginn einer Ära, in der Software nicht mehr bedient, sondern beauftragt wird.

Unternehmen, die frühzeitig Expertise im Aufbau und der Steuerung dieser autonomen Systeme entwickeln, werden einen signifikanten Effizienzvorsprung erzielen. Es gilt jetzt, die technische Basis zu schaffen und erste Pilotprojekte mit kontrollierten Agenten in unkritischen Bereichen zu starten.