Der technologische Wandel in der Softwareentwicklung wird oft an neuen Frameworks oder Hardware-Iterationen gemessen. Ein weitaus kritischerer Indikator für die Gesundheit des Ökosystems ist jedoch die Verfügbarkeit und Generierung von öffentlichem Wissen. Aktuelle Datenanalysen zum Status von Stack Overflow zeichnen ein besorgniserregendes Bild: Die Plattform, die über ein Jahrzehnt als das globale Gedächtnis der Entwicklergemeinschaft fungierte, erlebt eine Erosion ihrer Kernmetriken. Dies ist kein isoliertes Phänomen einer einzelnen Website, sondern ein Warnsignal für die gesamte Branche.

Analyse des Niedergangs: Datenbasierte Evidenz Quantitative Betrachtung der Beitragsraten

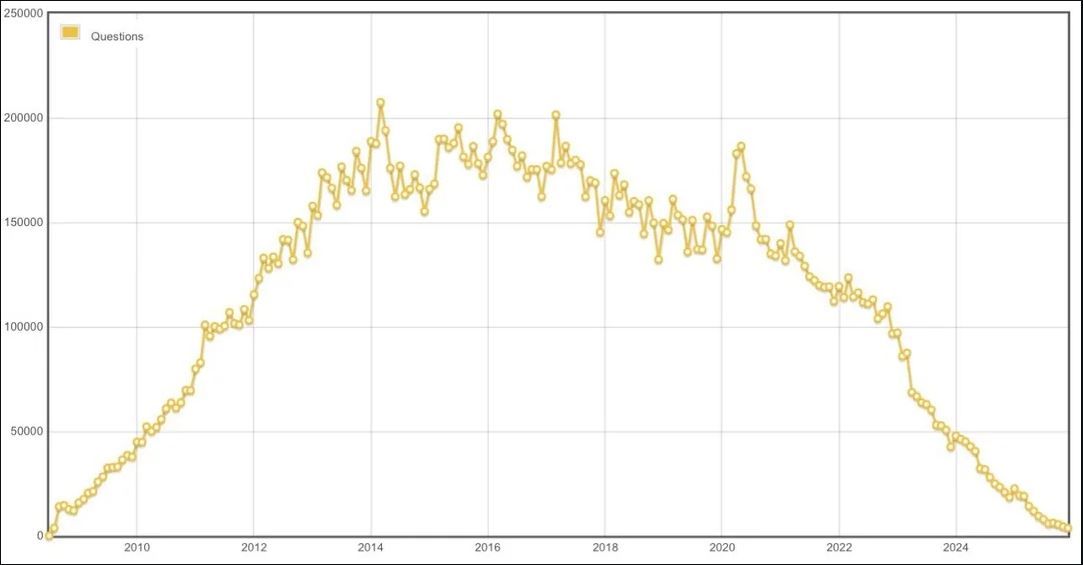

Die quantitative Analyse der monatlichen Fragen auf Stack Overflow offenbart eine drastische Trendwende. Während das Jahr 2014 mit einem Peak von circa 200.000 neuen Fragen pro Monat den Höhepunkt der kollektiven Wissensgenerierung markierte, zeigt die Kurve seit Ende 2022 einen beispiellosen Einbruch. Bis zum Dezember 2025 ist das Volumen auf das Niveau von 2009 zurückgefallen. Dieser Rückgang um über 90 % gegenüber dem Allzeithoch lässt sich nicht durch eine natürliche Marktsättigung erklären. Es handelt sich um eine strukturelle Verschiebung der Art und Weise, wie technisches Problemlösungswissen artikuliert und gespeichert wird.

Die Grafik zeigt die Statistiken der täglich bzw. monatlich eingehenden Fragen auf Stack Overflow im Zeitstrahl.

In einer Ökonomie, in der Antworten durch Large Language Models (LLMs) nahezu kostenlos und instantan verfügbar werden, steigt der Preis für öffentliche Sichtbarkeit und die Motivation zur Dokumentation massiv an.

Stack Overflow basierte auf einem positiven Netzwerkeffekt: Jede präzise formulierte Frage und jede validierte Antwort reduzierte die Transaktionskosten für nachfolgende Entwickler mit identischen Problemstellungen. Dieser Wissensspeicher fungierte als Beschleuniger für die gesamte Industrie. Fällt dieser Mechanismus weg, weil der individuelle Anreiz zur öffentlichen Publikation durch die Bequemlichkeit privater KI-Chats ersetzt wird, bricht der Kreislauf der Wissensreplikation zusammen.

Die Disruption durch LLMs Warum Geschwindigkeit das Archiv besiegt

Der primäre Vorteil von KI-basierten Assistenzsystemen ist die Reduktion der Latenzzeit. Während eine Antwort auf Stack Overflow – abhängig von der Komplexität und Community-Aktivität – Minuten, Stunden oder Tage in Anspruch nehmen kann, liefern LLMs Ergebnisse in Millisekunden. Dieser Effizienzvorteil hat den Hauptgrund für die öffentliche Interaktion eliminiert. Das Ergebnis ist eine Verschiebung von einem durchsuchbaren, permanenten Archiv hin zu flüchtigen, privaten Chat-Interaktionen. Dieser Effekt ist brutal: Weniger Fragen führen zu weniger frischen Antworten, was wiederum die Relevanz in Suchmaschinenergebnissen mindert und neue Nutzer abschreckt.

Kritische Kennzahlen für das Wissensmanagement: Um den tatsächlichen Supply an Know-how zu messen, müssen Unternehmen über bloße Aktivitätsmetriken hinausgehen. Relevante KPIs sind: Fragen pro 1.000 aktive Nutzer, die Time-to-First-Answer innerhalb interner Dokumentationen sowie das Volumen an neuem, indiziertem Content pro Monat.

Konsequenzen für Entscheider Vom Gedächtnisverlust zum operativen Risiko

Wenn eine Plattform wie Stack Overflow stirbt, verliert der Markt sein gemeinsames Gedächtnis. Für Unternehmen bedeutet dies konkret, dass das Onboarding neuer Mitarbeiter zäher wird, da die externe Wissensbasis veraltet. Fehler, die bereits an anderer Stelle gelöst wurden, müssen in geschlossenen Silos redundant neu bearbeitet werden. Der kurzfristige Produktivitätsgewinn durch KI-Support könnte somit langfristig durch steigende Kosten in der Fehlerbehebung und Wissenskonservierung teuer erkauft werden. Die Abhängigkeit von KI-Modellen, die auf eben jenem (nun versiegenden) öffentlichen Content trainiert wurden, stellt zudem ein systemisches Risiko für die Qualität künftiger Code-Antworten dar.

Technologieverantwortliche müssen erkennen, dass „KI hilft beim Support“ nur eine Oberflächenlösung ist. Die strategische Herausforderung liegt in der Frage: Woher kommt künftig verlässliches, validiertes Wissen, das über die Grenzen eines einzelnen Teams hinaus auffindbar bleibt?

Strategische Empfehlung: Etablieren Sie eine dedizierte Wissens-Pipeline. Transformieren Sie Ad-hoc-Lösungen aus privaten Chats oder internen Tickets systematisch in kuratierte, dauerhaft durchsuchbare Artikel. Messen Sie den Content-Nachschub mit der gleichen Priorität wie Ihren Umsatz.

Resümee: Der Preis der Bequemlichkeit Wissenstransfer in der Post-Stack-Overflow-Ära

Die Erosion von Stack Overflow markiert das Ende einer Ära des radikal offenen Wissensaustauschs. KI hat nicht nur die Generierung von Antworten beschleunigt, sondern gleichzeitig den Anreiz zerstört, Wissen für die Allgemeinheit zu hinterlassen. Wir befinden uns in einem Übergang von einer Pull-basierten Wissenskultur (Suche im Archiv) hin zu einer Push-basierten, aber flüchtigen Kultur (generative Antwort). Wer diesen Prozess nicht aktiv steuert, riskiert den Verlust der technischen Souveränität innerhalb seiner Organisation.

Es gilt, neue Anreizsysteme zu schaffen, die den Wert der Dokumentation und der öffentlichen Validierung von Lösungen betonen. Ohne diesen Nachschub an frischem, realitätsgeprüftem Wissen werden auch die zugrundeliegenden KI-Modelle langfristig an Präzision verlieren.

Handlungsimpulse Schritte zur Sicherung des technischen Kapitals

Das Ignorieren dieser Entwicklung führt zu signifikanten versteckten Kosten. Wenn die Suchbarkeit von Lösungen sinkt, steigt die Redundanz in der Entwicklung. Teams verbringen mehr Zeit damit, Rad-neu-zu-erfinden, anstatt auf validierten Best Practices aufzubauen. Ein proaktives Wissensmanagement ist daher kein optionales „Good-to-have“, sondern eine operative Notwendigkeit zur Sicherung der Skalierbarkeit. Die Transformation vom passiven Konsumenten zum aktiven Kurator von Wissen innerhalb der eigenen Organisation ist der entscheidende Wettbewerbsvorteil der kommenden Jahre.

Untersuchen Sie Ihre internen Prozesse: Wie viele Ihrer Problemlösungen landen in einem durchsuchbaren Format und wie viele verschwinden in ephemeren Chat-Verläufen? Die Antwort auf diese Frage bestimmt Ihre zukünftige Effizienz.

Fazit: KI hat den Zugang zu Information demokratisiert, aber die Produktion von neuem, validiertem Wissen gefährdet. Unternehmen, die diesen Widerspruch durch eigene Wissens-Pipelines auflösen, werden langfristig erfolgreicher agieren als jene, die sich rein auf externe, versiegende Quellen verlassen.

Wissensmanagement FAQ Herausforderungen und Lösungsansätze

LLMs benötigen qualitativ hochwertige, aktuelle Daten für ihr Training. Wenn die Generierung von neuem, öffentlichem Wissen stagniert, fehlt die Grundlage für zukünftige Modell-Updates bezüglich neuer Technologien und Edge-Cases.

Die Beobachtung der globalen Entwicklerdynamik zeigt, dass wir an einem Wendepunkt stehen. Die technologische Souveränität von morgen hängt davon ab, wie wir heute mit der Ressource Wissen umgehen. Es ist an der Zeit, Dokumentation nicht mehr als lästige Pflicht, sondern als wettbewerbsrelevantes Asset zu begreifen.

Ausblick 2026 Die Evolution der Experten-Communities

Wir prognostizieren eine Fragmentierung des Wissens in spezialisierte, oft geschlossene Fach-Communities. Während die Ära der einen großen Q&A-Plattform endet, wird die Bedeutung von verifizierten Experten-Netzwerken zunehmen. Die Herausforderung für die RheinMainTech GmbH und unsere Partner wird es sein, diese neuen Informationsströme effizient zu nutzen und gleichzeitig zur Integrität der globalen Wissensbasis beizutragen.

Die Zukunft gehört nicht jenen, die die schnellsten Antworten finden, sondern jenen, die sicherstellen, dass die Antworten auch in fünf Jahren noch auffindbar und korrekt sind.

Wir beobachten die Entwicklung weiterhin genau und unterstützen unsere Kunden bei der Implementierung nachhaltiger Wissensstrategien in einer KI-zentrierten Welt.